Traditionnellement, les conflits d’usage autour de l’eau concernent d’avantage l’agriculture que les autres secteurs : avec 58% de la consommation d’eau douce allouée1 à l’agriculture en France, c’est de loin l’activité la plus consommatrice. Ces conflits se sont actualisés, par exemple, très récemment en France à Sainte-Soline au sujet de la construction de méga-bassine2. En comparaison de ces quantités, la consommation d’eau des datacenters paraît dérisoire, pourtant le problème se pose de plus en plus régulièrement, et avec de plus en plus d’insistance. Pourquoi ?

Les datacenters ont chaud

Pourquoi un datacenter consomme de l’eau ? Pour refroidir le bâtiment et les machines qu’il contient.

Plus spécifiquement, les serveurs & autres matériel informatiques fonctionnent à l’électricité, quand l’électricité circule à travers ces machines, le matériau oppose une résistance. En vainquant cette résistance, le courant électrique dissipe de l’énergie sous forme de chaleur, chaleur qu’il faut évacuer. C’est aussi le cas avec tout nos appareils électroniques : ordinateur, smartphone, télévision, poste radio, etc.

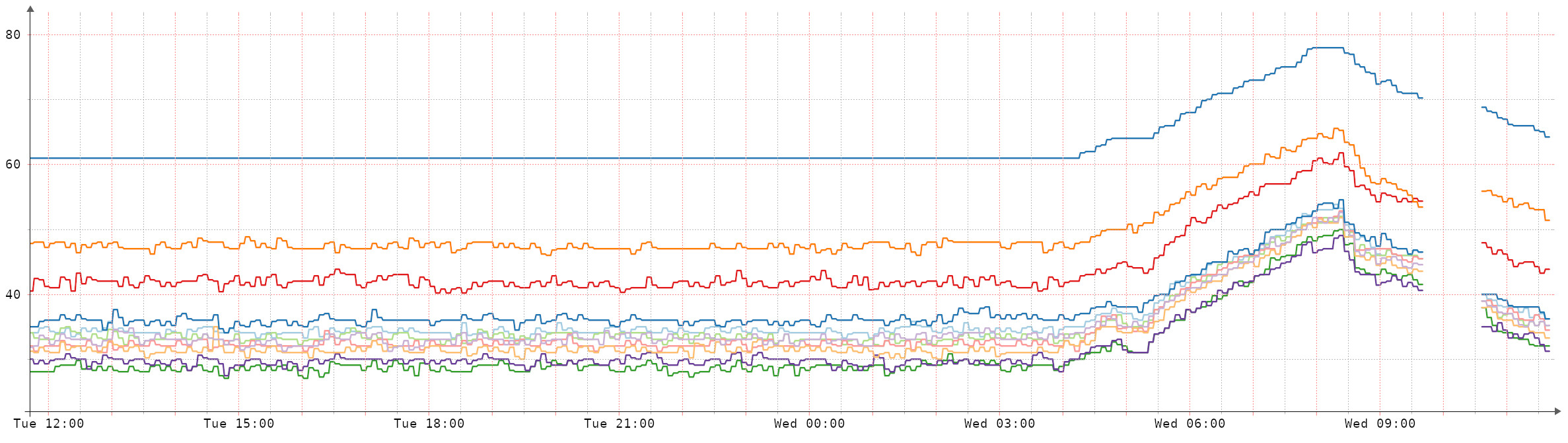

La différence entre les objets du quotidien et les datacenters, c’est la densité. Au quotidien, nos appareils dissipent sans problème la chaleur dans l’air ambiant, parfois accompagné d’un petit ventilateur pour favoriser les échanges thermiques, mais rien de plus. Dans un datacenter, la densité de machines est telle que si aucun refroidissement de l’air n’est mis en place, la température de la pièce va se mettre à monter en flèche. Par exemple, lors d’une panne du système de refroidissement du datacenter Global Switch à Clichy, la température a augmenté linéairement de +20°C en 3h (cf figure en dessous).

Température observés par différentes sondes d’un serveur dans le datacenter Global Switch le 26 avril 2023 lors d’une panne du système de refroidissement. Extrait du message de Vivien sur le forum lafibre.info.

Température observés par différentes sondes d’un serveur dans le datacenter Global Switch le 26 avril 2023 lors d’une panne du système de refroidissement. Extrait du message de Vivien sur le forum lafibre.info.

Passé un premier seuil de température, les composants fonctionnent moins vite et peuvent s’user plus rapidement. Passé un second seuil, ils ne peuvent plus fonctionner sans risque et, normalement, se mettent en sécurité en s’arrêtant. Pour assurer le fonctionnement en continu du datacenter, il n’y a donc pas de choix : il faut rafraîchir l’air qui se trouve à l’intérieur !

Refroidir avec de l’air, refroidir avec de l’eau

Tous les datacenters ne consomment pas de l’eau pour être refroidi, et ça n’a pas toujours été le cas. Historiquement, le plus simple pour refroidir les salles à l’intérieur du bâtiment était d’utiliser la climatisation, comme on peut trouver chez les particuliers ou dans les magasins, cinéma, et autres lieux accueillants du public. C’est aussi le même type de systèmes que l’on trouve dans nos réfrigérateurs.

La climatisation fonctionne avec un gaz, en circuit fermé, qui est compressé à l’extérieur du bâtiment ce qui génère de la chaleur (et réchauffe d’ailleurs les villes l’été), et décompressé (détendu) à l’intérieur du bâtiment, ce qui capte de la chaleur (et donc refroidit la pièce). Pour compresser le gaz, on a besoin d’un compresseur, qui fonctionne bien souvent à l’électricité et consomme de l’énergie. Dans le cadre d’un datacenter, cette consommation d’énergie peut représenter autant que la consommation électrique des serveurs à l’intérieur des datacenters3 : pour 2W dépensé, 1W sert au serveur, 1W sert à le refroidir avec la climatisation. D’ailleurs une métrique très célèbre chez les professionnels du milieu, nommée PUE, quantifie ce ratio entre électricité consommée par les serveurs, et électricité totale consommée (donc avec le refroidissement en plus). Dans mon exemple, on a un PUE de 2, là où 1 est une valeur idéale (0 énergie consacrée au refroidissement).

La consommation d’énergie pour refroidir les serveurs est devenu un sujet central dans les 10 dernières années pour les opérateurs de datacenter, surtout ceux à grande échelle, car réduire la consommation d’énergie pour le refroidissement permet de réaliser des économies substantives sur la facture d’électricité. De nombreuses méthodes de refroidissement ont été développées4. Généralement, le plus simple, c’est de recourir aux courants d’air (free cooling), autrement dit de faire circuler de l’air dans le bâtiment qui est plus fraîche que la température à laquelle on veut maintenir la salle. Ça marche bien quand il fait froid dehors, mais pas en plein été : la température cible à l’intérieur du datacenter est souvent comprise autour de 20°C à 25°C, voire jusqu’à 28°C pour OVH mais guère plus. Quant il fait plus chaud, il faut éteindre les serveurs… Non je rigole, malgré les promesses de Google en 2007, la réalité c’est qu’on utilise d’autres modes de refroidissement.

Dans cet article, on va se concentrer sur le refroidissement à l’eau (water-cooling), et plus spécifiquement le refroidissement adiabatique (d’autres méthodes existent mais c’est elle que je connais le mieux). On sait que cette technologie est déployée par Scaleway (Free) en France5 et Microsoft6, et on verra plus loin que je suspecte Google aussi d’en faire usage.

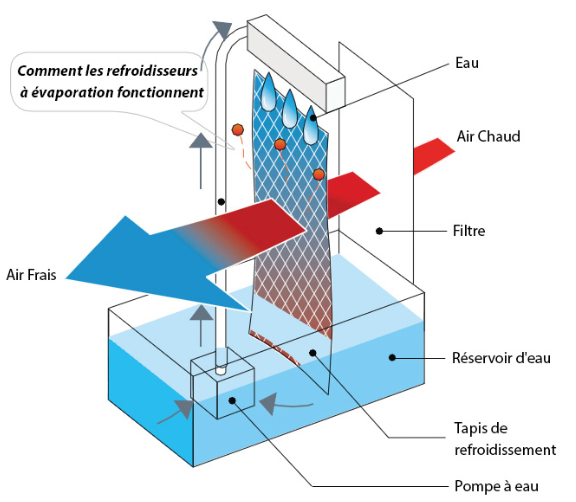

Le refroidissement adiabatique, c’est l’équivalent de la serviette mouillée accrochée à la fenêtre de votre vieille voiture sans climatisation dans l’espoir de refroidir un peu l’habitacle, ou sur votre ventilateur pour rafraîchir un peu la pièce.

Exemple d’un système adiabatique artisanal avec une serviette et un ventilateur par l’Agence Parisienne du Climat

Exemple d’un système adiabatique artisanal avec une serviette et un ventilateur par l’Agence Parisienne du Climat

Les deux systèmes fonctionnent de la même manière : ils comptent sur la capacité de l’eau à capter une grande quantité de chaleur pour passer de liquide à vapeur. Au passage l’hygrométrie (l’humidité de l’air) augmente : une fois que l’air a refroidit sa cible, il est important donc de l’évacuer pour pas que l’eau sous forme de vapeur s’accumule. Qui dit évacuation de l’air à forte hygrométrie dit donc consommation d’eau.

Exemple d’un système adiabatique industriel par l’Agence Parisienne du Climat.

Exemple d’un système adiabatique industriel par l’Agence Parisienne du Climat.

Par contre, l’échelle des deux systèmes est radicalement différente, et donc pour fonctionner il faut avoir beaucoup d’eau à vaporiser. Je n’ai pas réussi à trouver des quantifications / modèles publiques qui estimeraient pour une quantité données de chaleur, la quantité d’eau consommées par de tels systèmes. Plus loin, on aura cependant des estimation de volume d’eau consommées par les datacenters de Google et Microsoft pour le refroidissement, sans expliquer en détail quel refroidissement est utilisé. Avec l’exemple de ce système adiabatique, on comprend donc comment l’eau est consommée : par évaporation et rejet dans l’atmosphère.

Des conflits de plus en plus sérieux

Microsoft a fait preuve à minima d’imprécision aux Pays-Bas sur la consommation d’eau de ses datacenters7 : annonçant une consommation entre 12 000 et 20 000 m3 par an, un quotidien local a révélé que Microsoft en a consommé 84 000 m3 sur l’année 2021 (soit au moins 4x plus). Microsoft a réagi en mentionnant que 2021 était l’année de construction et non une année normale d’opération, ce qui expliquerait la consommation plus importante.

Le datacenter principale de Google en Europe se trouve en Belgique, à Saint Ghislain, près de la ville de Mons et de la frontière Française. Chaque année, ce datacenter prélève plus d’1 million de m3 d’eau non potable dans le canal adjacent8, soit l’équivalent de la consommation en eau de ~10 000 personnes dans la région9. Une partie de cette eau, réchauffée, est cependant réinjectée dans le canal.

Dans la ville de Dalles dans l’Oregon (à ne pas confondre avec Dallas), Google consomme là aussi un peu plus d’1 million de m3 d’eau en 2020, soit un quart des ressources en eau de la ville de 16 000 habitants10. Cette consommation a doublé en 2 ans, et triplé en 10 ans. La région étant sèche et la ville s’étant engagée à allouer d’avantage d’eau à Google pour ses futurs datacenters, des associations citoyennes locales s’interrogent sur les futurs impacts de cette consommation d’eau sur les écosystèmes locaux. À noter que ces chiffres ont été arrachés à Google à la suite d’un procès opposant l’entreprise à un journal local.

Plus récemment, Google planifie l’installation d’un datacenter en Uruguay, dans la ville de Montevideo11. La ville souffre déjà de sévères restrictions d’eau : l’eau du robinet est salée car à cause de la sécheresse, l’eau est maintenant pompée dans l’estuaire du Rio de la Plate, là où l’eau salée de la mer vient se mélanger à l’eau douce. Des mesures d’urgence ont été prises par la ville, avec la distribution de 21 000 bouteilles d’eau aux familles les plus pauvres. En regard de ça, Google prévoit de consommer 7 600 m3 d’eau par jour, annualisé cela représente presque 3 millions de m3 d’eau par an. Soit l’équivalent de la consommation en eau de 55 000 personnes selon le ministère de l’environnement Uruguayen.

Les changements climatiques en toile de fond

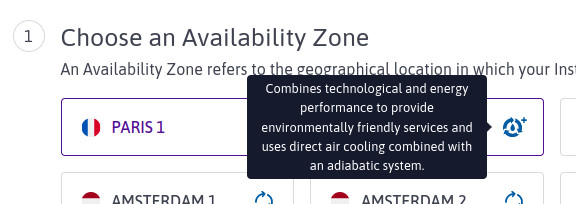

Le refroidissement adiabatique n’a commencé à être déployé à grande échelle que récemment. Si on prend l’exemple de Scaleway (Free), sur l’historique de leurs 5 datacenters construits entre 1989 et 2019, seul le dernier datacenter est refroidi via un système adiabatique. Le combo “adiabatique + free cooling” est d’ailleurs mis en avant dans leur interface cloud. Ce qui me fait dire qu’on assiste peut-être là à un déplacement de la consommation d’électricité à la consommation d’eau pour le refroidissement dans le monde des datacenters.

Les datacenters sont localisés géographiquement à un seul endroit, et non réparti sur le territoire comme l’agriculture. Si leur consommation en eau peut paraître dérisoire (pour le moment) à l’échelle de certains pays (probablement pas l’Uruguay), elle ne l’est jamais comparativement à la commune qu’ils jouxtent, et donc sur les populations locales et écosystèmes environnants.

Aujourd’hui, malgré la focalisation sur l’eau, le système de refroidissement privilégié reste les courants d’air, le free-cooling. L’eau est surtout utilisée quand la température extérieure dépasse un seuil critique, censé n’être atteint que quelques jours par ans. Si ce seuil critique venait à être dépassé 2x, 5x, voire 10x plus de fois qu’avant, devrions-nous nous attendre à une hausse de la consommation d’eau des mêmes ordres de grandeurs ? Et ce, en plus, dans une période de sécheresse, et donc où les tensions sur l’eau sont déjà fortes ?

Avec le développement des datacenters (plus grands, plus nombreux) et les effets du changement climatique sur les températures et les sécheresses, je me demande si nous ne faisons pas face aux prémices d’un conflit bien plus sérieux sur l’eau, certes localisé (proche des datacenters), certes limité dans le temps (probablement l’été) mais potentiellement dévastateur pour les gens qui vont le vivre (comme le montre l’exemple de l’Uruguay). Loin d’être anecdotique, ce sujet commence à interroger jusqu’aux professionnels du secteur12, bien qu’ils ne faillent probablement pas attendre une solution satisfaisante de leur part.

Penser Internet sans les datacenters ?

Comme en témoigne les multiples conflits d’usages qu’ils créent (d’abord l’électricité, aujourd’hui l’eau, demain le foncier), les datacenters déstabilisent les territoires dans lesquels ils sont installés. Il y a une différence entre leur usage, leur rayon d’action, qui se pense à l’échelle nationale voire continentale, et leur impact, localisé à l’échelle d’une ville : la même consommation de ressource qui semble négligeable à l’échelle des usagers, devient insoutenable à l’échelle des populations habitant proche du datacenter.

Ne vous y trompez pas, ici il ne s’agit pas d’un plaidoyer pour la dispersion de la même quantité de calcul et de stockage d’information à travers le territoire, car la résolution, du moins l’invisibilisation de ces conflits, se ferait alors au prix de la perte des économies d’échelles réalisées dans ces cathédrales numériques, ce qui créerait sans aucun doute de nouveaux problèmes.

L’idée serait donc plutôt d’accepter des limites, des seuils, dans notre déploiement et notre usages d’Internet et du numérique, des réflexions qui commencent à se frayer une route sous le nom aussi de computing within limits13. Je vois donc ce billet comme le premier d’une série pour repenser notre relation à Internet, imaginer une relation plus saine qui s’affranchisse de ces “usines bruyantes et maladroites” que sont les datacenters, et l’action de Deuxfleurs comme une première tentative de mise en œuvre de cette réflexion.

Sources

Prélevée ou consommée : comment compter (sur) l’eau ?

2: Mégabassine de Sainte-Soline : 7 questions pour comprendre le projet et les manifestations pour l’empêcher

3: (2016) L’efficacité énergétique dans les datacenters

4: Refroidir efficacement les datacenters

5: Visite du data center Scaleway DC5 (refroidissement adiabatique)

6: (2021) Microsoft : refroidissement adiabatique au Wyoming

7: Water in, data out: Microsoft underestimates Dutch centre’s thirst

8: À Mons, Google consomme un million de mètres cubes d’eau par an pour son data center

9: Google data centre in Belgium the most ‘water-hungry’ in Europe

10: We now know how much water Google’s Oregon data centers use, after city drops lawsuit against journalists

11: ‘It’s pillage’: thirsty Uruguayans decry Google’s plan to exploit water supply

14: Scaleway, notre engagement environnemental

12: Tribune – La datacenter et l’eau, la controverse… l’exemple de Google à The Dalles

13: Computing within Limits

Comments

No comments yet. Be the first to react!